par Xukyo | 15 Jan 2024 | Tutoriels

Nous allons voir comment mettre en place une communication entre un serveur et un client en utilisant le protocole Websockets sous Python. WebSockets est un protocole de communication web simple et robuste permettant la communication en temps réel. Installation de la...

par Xukyo | 11 Jan 2024 | Tutoriels

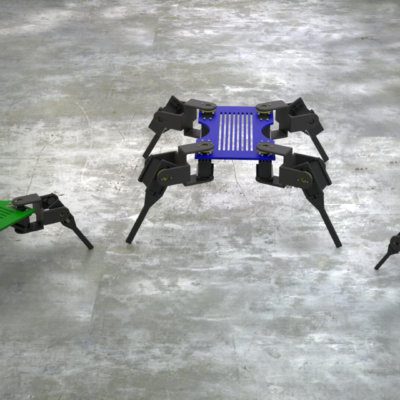

Dans ce tutoriel, nous allons voir comment créer et lancer des script Python sous ROS2. Vous pourrez ainsi créer vos propres noeuds et commencer à développer sous ROS. Créer un espace de travail Une bonne pratique pour développer sous ROS2 est de créer des workspaces...

par Xukyo | 10 Jan 2024 | Tutoriels

Dans ce tutoriel, nous allons voir comment installer ROS2 sur une machine Linux et notamment un Raspberry Pi 4 avec une distribution Ubuntu. ROS2 est un framework intéressant à abordé lorsqu’on travaille sur des systèmes embarqués comme les robots. Matériel...

par Xukyo | 29 Déc 2023 | Tutoriels

Le Bluetooth Low Energy (BLE) a une limitation connue d’une 20Bytes pour la longueur des chaînes envoyées. Ils existent des méthodes pour outrepasser cette limite. Matériel Dans ce tutoriel, nous envoyons des données à partir d’une application Android,...

par Xukyo | 27 Déc 2023 | Tutoriels

Nous allons voir dans ce tutoriel comment donner la parole à votre appareil Android avec une librairie Text to Speech (TTS). Que ce soit pour développer des applications pour malvoyant ou pour donner plus de vie à votre système Android, donner la parole à votre projet...

par Xukyo | 8 Nov 2023 | Tutoriels

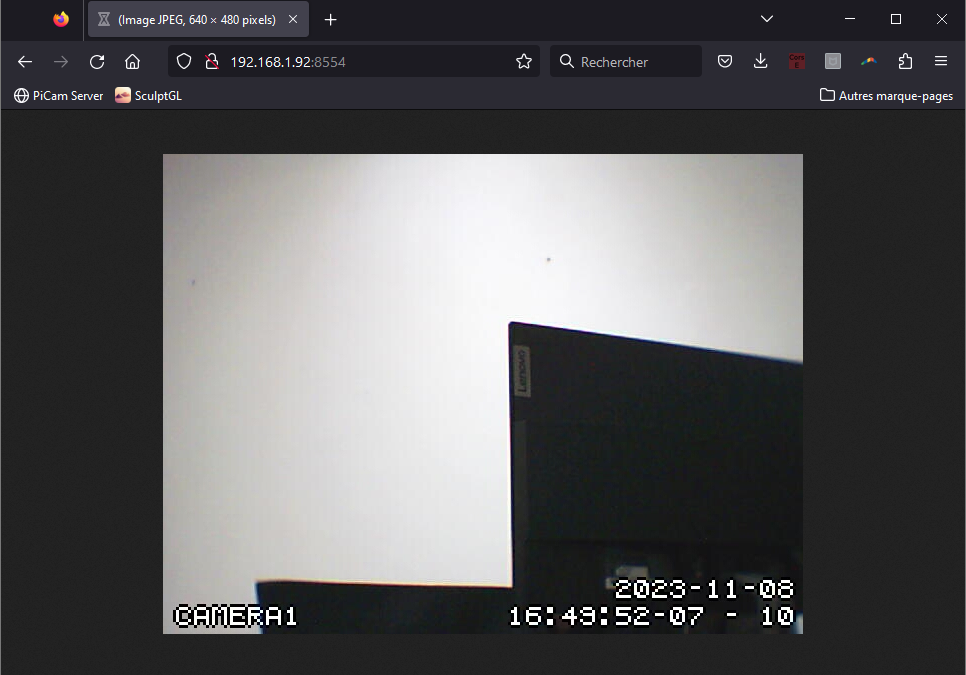

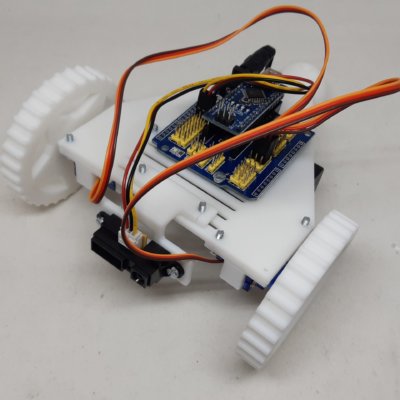

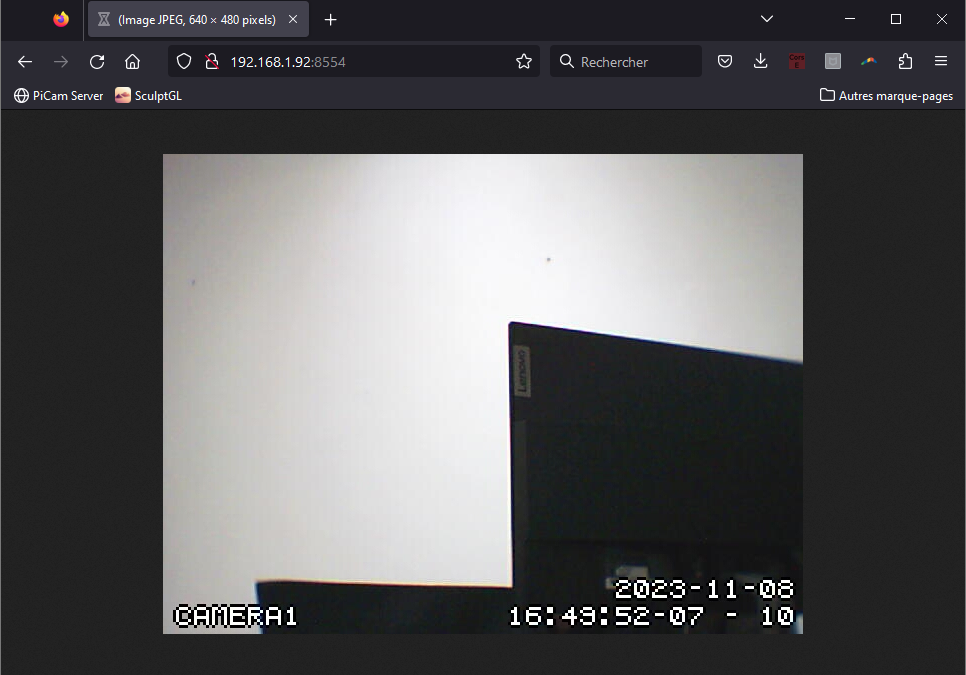

Nous allons voir dans ce tutoriel comment récupérer un flux vidéo Motion sur une application React Native. Configuration du projet Nous avons mis en place un stream vidéo avec Motion sur une machine Linux dont l’adresse est 192.168.1.92:8554 sur le réseau Wifi....

par Xukyo | 8 Nov 2023 | Tutoriels

Nous allons voir dans ce tutoriel comment mettre en place un stream vidéo avec Motion à partir d’un Raspberry Pi. Ce tutoriel reste compatible avec tout système Linux. Matériel Raspberry Pi (ou autre machine linux) Caméra USB ou Caméra CSI Description de Motion...