por Xukyo | 24 Ene 2025 | Tutoriales

El editor de código VSCode permite crear y desarrollar proyectos en diversos lenguajes de programación, como Python y C++, gracias a una serie de extensiones. Instalación de VSCode Si aún no lo ha hecho, descargue e instale VSCode Utilizar un editor de código como...

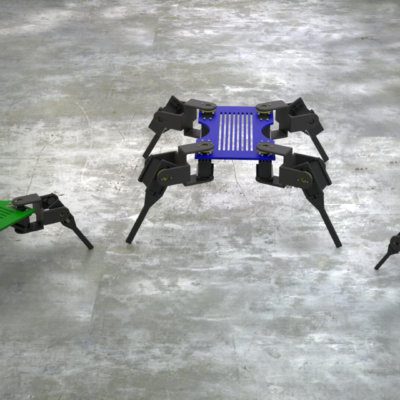

por Xukyo | 30 Sep 2024 | Tutoriales

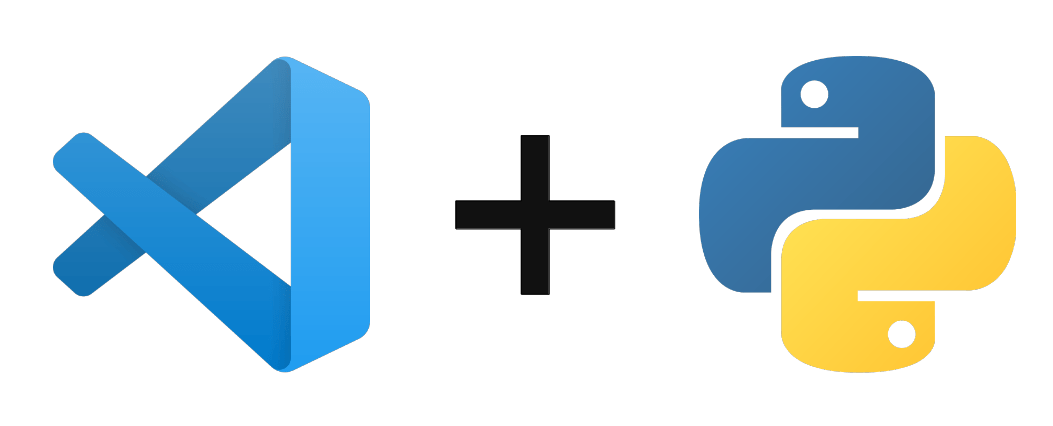

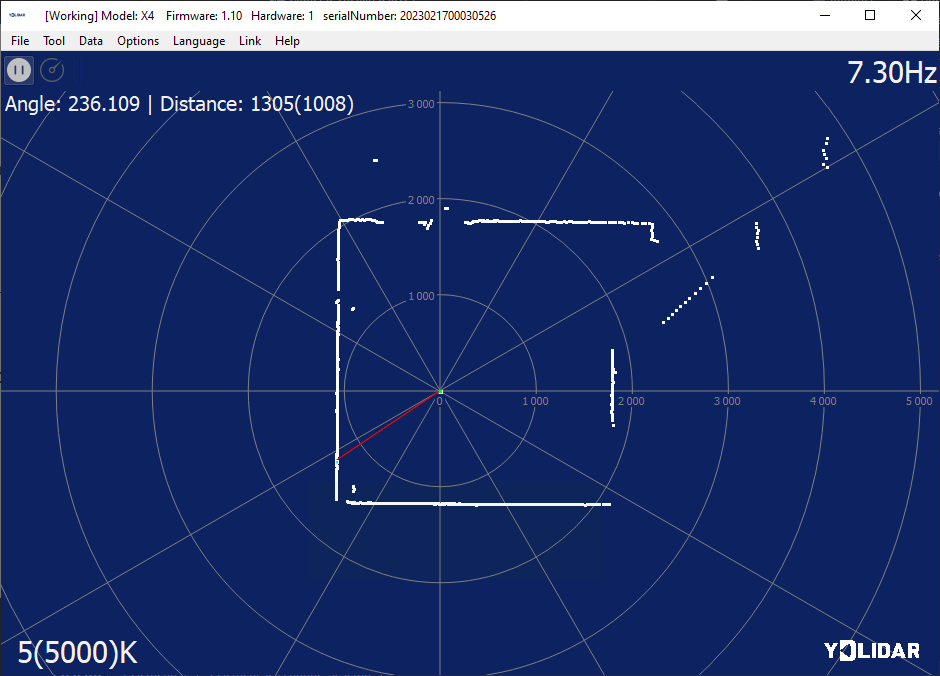

En este tutorial, veremos cómo configurar un mapa utilizando un sensor Lidar en Python. El sensor Lidar se utiliza para encontrar su orientación en el espacio y para mapear. Descripción del sensor Lidar El sensor lidar es un sensor láser de distancia acoplado a un...

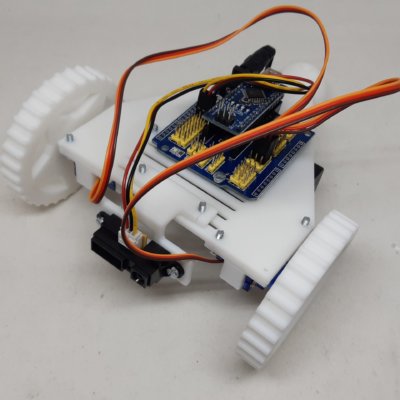

por Xukyo | 27 Ago 2024 | Tutoriales

,En este tutorial, aprenderemos a gestionar y probar la comunicación BLE (Bluetooth Low Energy) en un ESP32 usando MicroPython. Equipamiento Un módulo ESP32 Un ordenador con Python instalado Cable USB para conexión ESP32-ordenador Un dispositivo Android Configuración...

por Xukyo | 8 Abr 2024 | Tutoriales

Para recopilar datos en Internet, puedes crear un Web crawler o Web scraping con Python. Un rastreador web es una herramienta que extrae datos de una o varias páginas web. Configuración del entorno Python Asumimos que Python3 y pip están instalados en tu máquina....

por Xukyo | 3 Abr 2024 | Tutoriales

Vamos a ver cómo configurar la comunicación entre un servidor y un cliente utilizando el protocolo Websockets en Python. WebSockets es un protocolo de comunicación web simple y robusto para la comunicación en tiempo real. Instalación de la biblioteca Websockets Para...