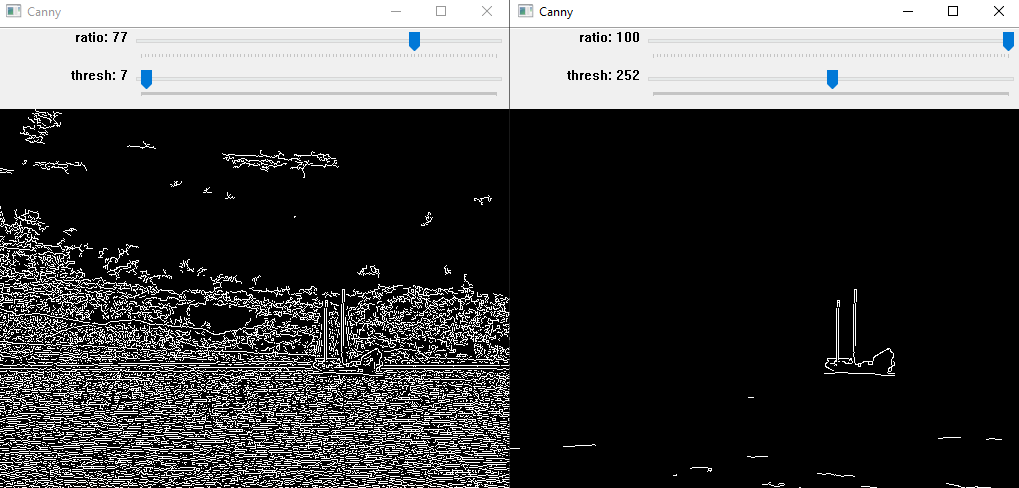

par Xukyo | 26 Nov 2024 | Tutoriels

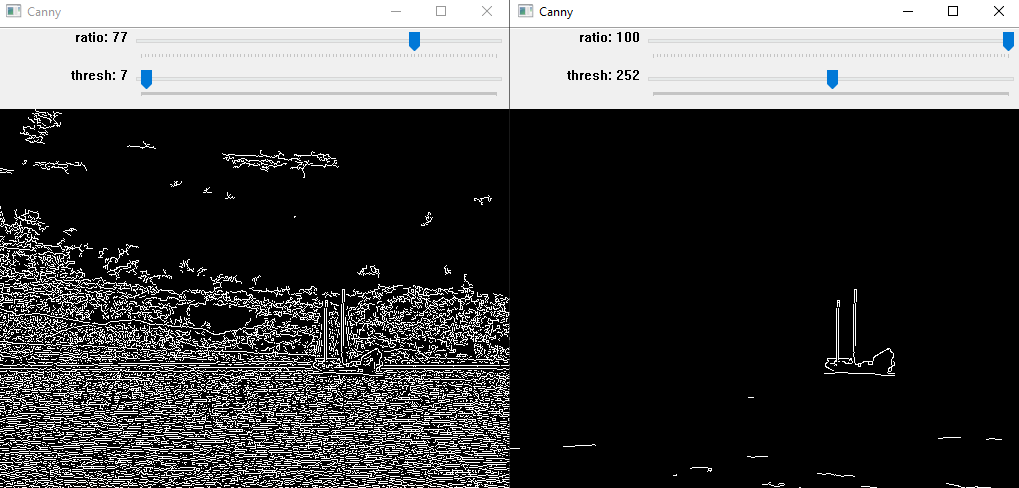

Nous allons voir dans ce tutoriel comment implémenter un algorithme de détection de contour avec Python et OpenCV. La détection de contour est un exercice primordiale pour la vision assistée par ordinateur et la reconnaissance d’objet. Installation et...

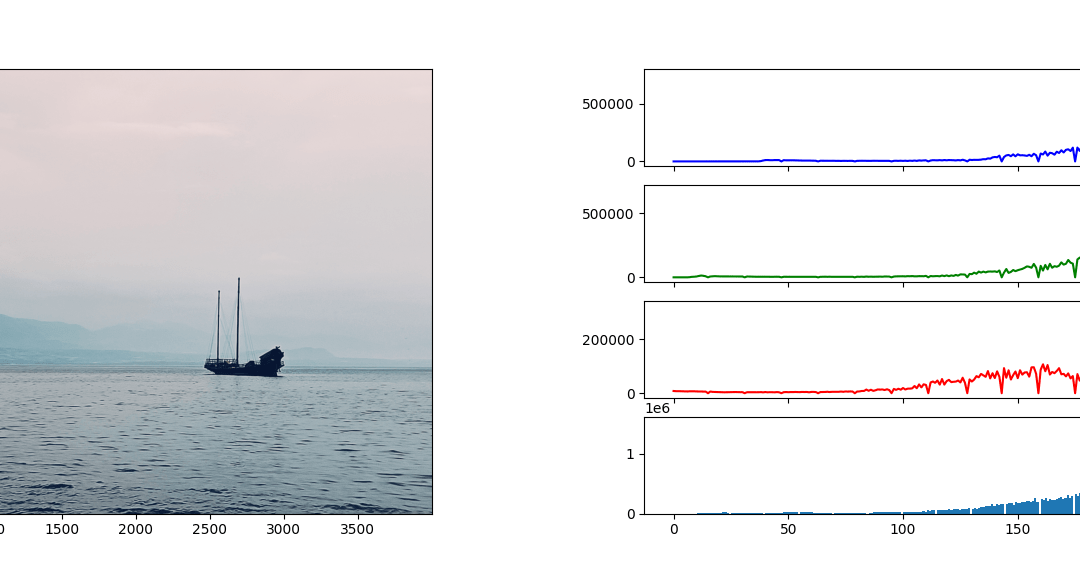

par Xukyo | 20 Nov 2024 | Tutoriels

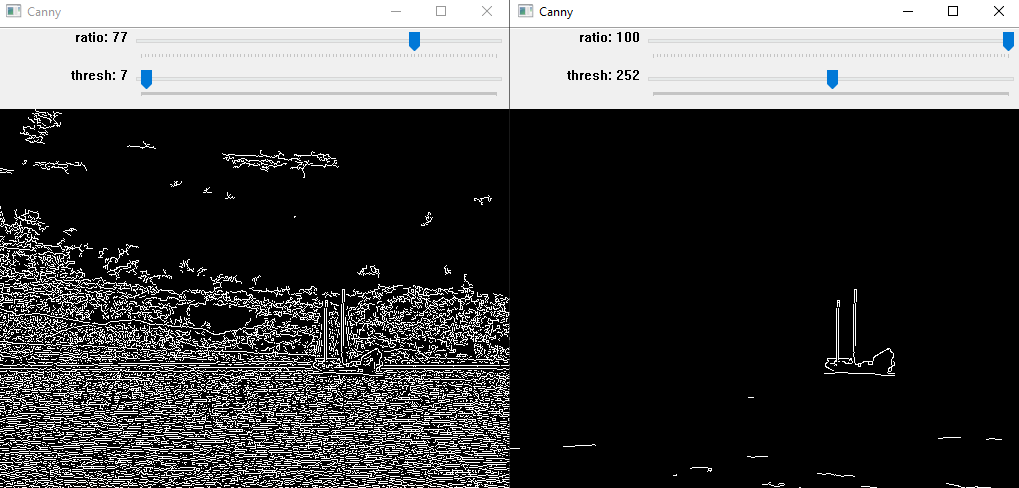

Le module open-source OpenCV est un outil puissant de traitement d’image contenant des algorithmes de vision par ordinateur. Ce module est codé nativement en C++ mais une API est disponible sur Python. On l’utilise pour le traitement d’image, photo...

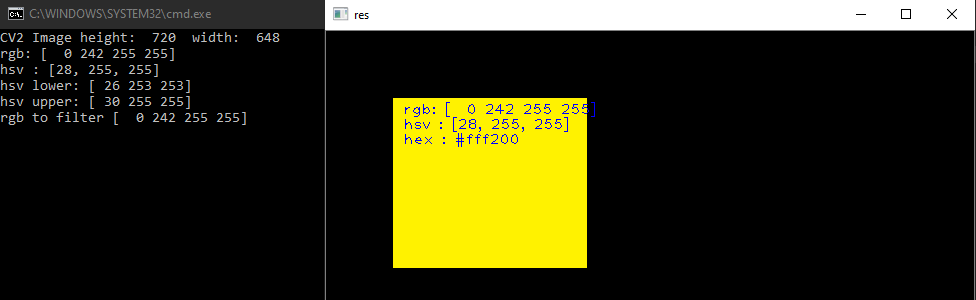

par Xukyo | 19 Nov 2024 | Tutoriels

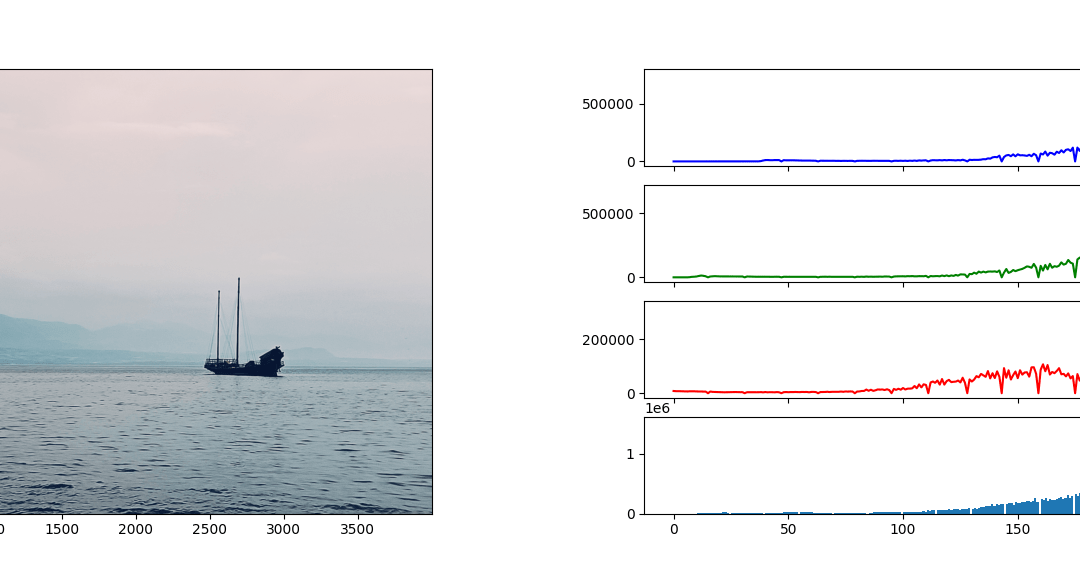

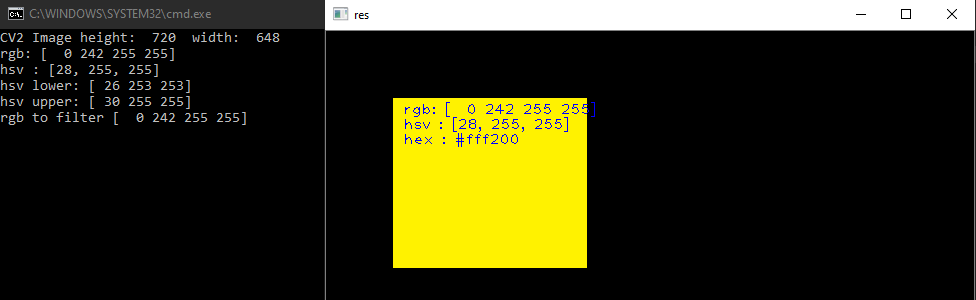

Lors de traitement d’image, il peut être intéressant de filtrer une couleur pour la modifier, la garder ou la supprimer. Nous allons voir dans ce tutoriel comment sélectionner et filtrer une zone de couleur avec OpenCV et Python. Traitement d’image Pour ce...

par Xukyo | 23 Août 2023 | Tutoriels

Nous allons voir dans ce tutoriel comment faire de la reconnaissance d’objet avec Yolo et OpenCV en utilisant un réseau de neurones pré-entrainé grâce au deep learning. Nous avons vu dans un précédent tutoriel comment reconnaitre des formes simples avec la...

par Xukyo | 12 Avr 2023 | Tutoriels

Nous allons voir dans ce tutoriel comment faire de la reconnaissance de texte à partir d’une image avec Python et Tesseract. Tesseract est un outil permettant de reconnaitre des caractères, et donc du texte, contenus dans une image (OCR, Optical Characters...