por Xukyo | 29 Feb 2024 | Tutoriales

En este tutorial, veremos cómo realizar el reconocimiento de objetos con Yolo y OpenCV utilizando una red neuronal pre-entrenada utilizando deep learning. En un tutorial anterior vimos cómo reconocer formas simples mediante visión por ordenador. Este método sólo...

por Xukyo | 24 Feb 2024 | Tutoriales

En este tutorial veremos cómo reconocer texto de una imagen utilizando Python y Tesseract. Tesseract es una herramienta para reconocer caracteres, y por tanto texto, contenidos en una imagen (OCR, Optical Character Recognition). Instalación de Tesseract En Linux Para...

por Xukyo | 13 Feb 2024 | Tutoriales

Para ciertas aplicaciones, puede resultarte útil incrustar OpenCV en una interfaz PyQt. En este tutorial, veremos cómo integrar y gestionar correctamente un vídeo capturado por OpenCV en una aplicación PyQt. N.B.: Utilizamos Pyside, pero la conversión a PyQt es...

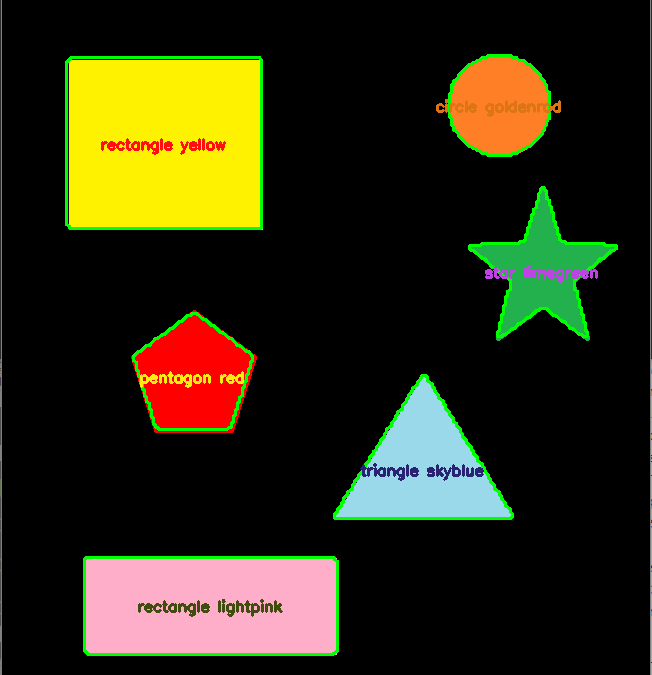

por Xukyo | 29 Nov 2023 | Tutoriales

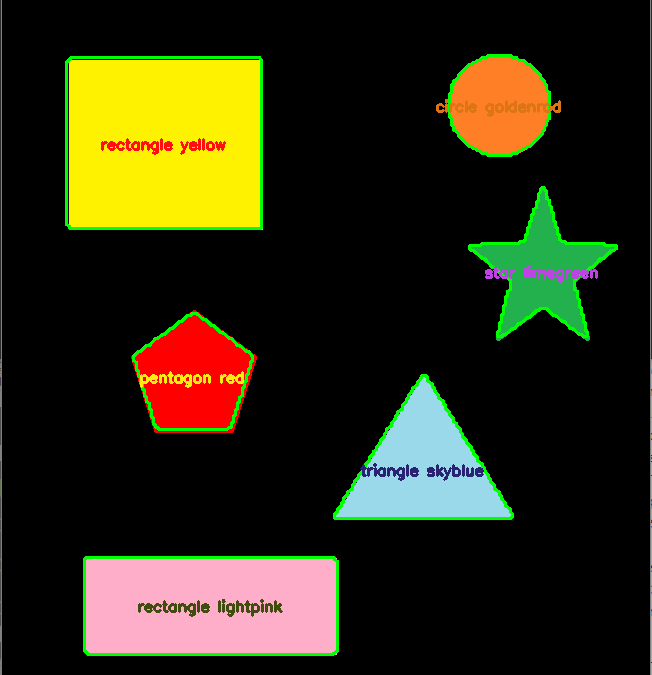

, La biblioteca OpenCV se utiliza para el procesamiento de imágenes, en particular el reconocimiento de formas y colores. La biblioteca tiene funciones de adquisición y algoritmos de procesamiento de imágenes que hacen que el reconocimiento de imágenes sea bastante...

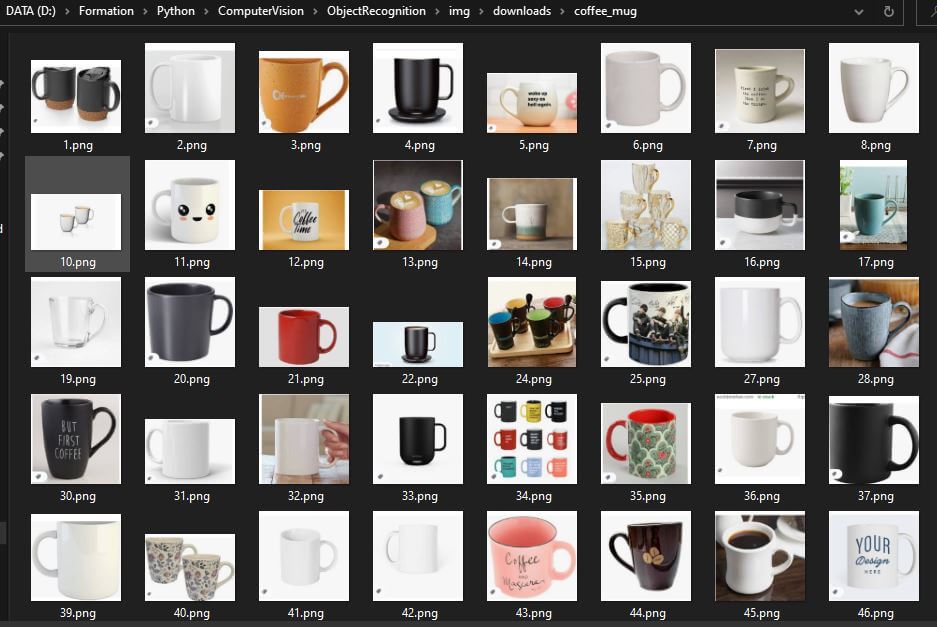

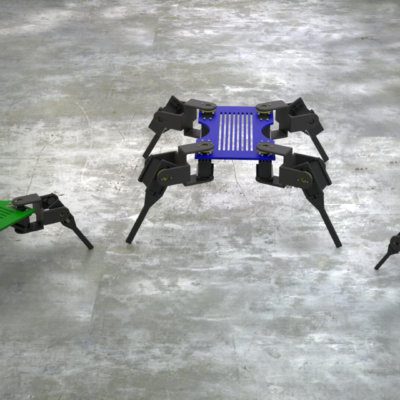

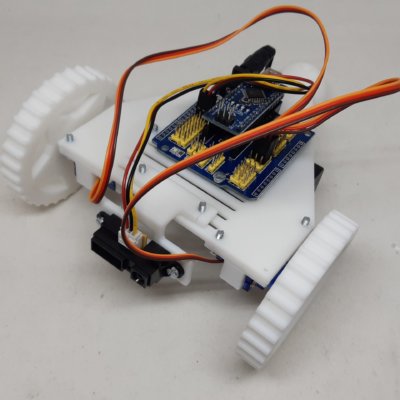

por Xukyo | 1 Ago 2023 | Tutoriales

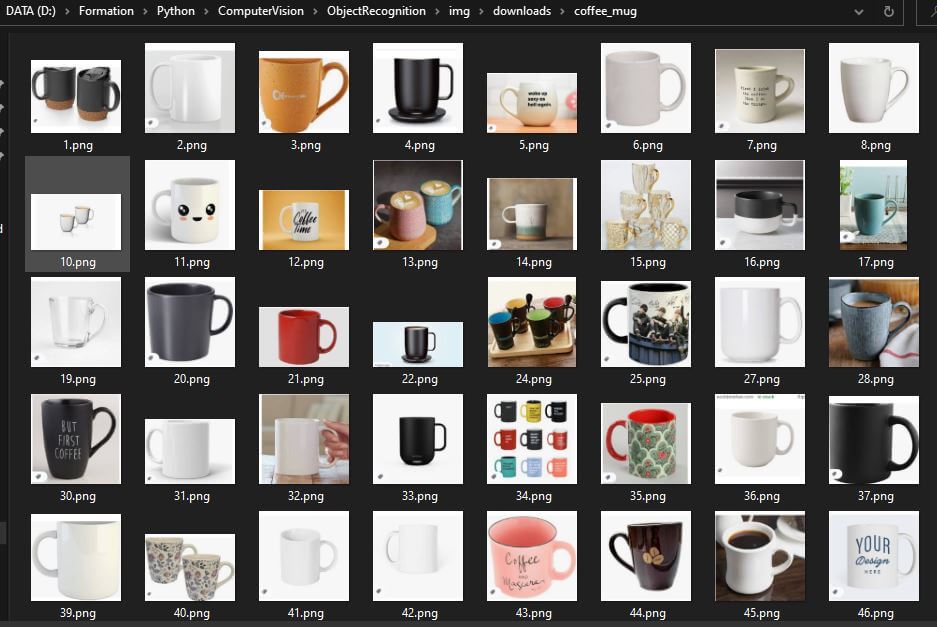

, , Para entrenar una red neuronal en detección y reconocimiento de objetos, se necesita un banco de imágenes con el que trabajar. Veremos cómo descargar un gran número de imágenes de Google utilizando Python. Para entrenar una red neuronal, necesitas una gran...