by Xukyo | 29 Mar 2024 | Tutoriais

Neste tutorial, vamos ver como dar uma voz ao seu dispositivo Android utilizando uma biblioteca Text to Speech (TTS). Quer esteja a desenvolver aplicações para pessoas com deficiência visual ou a tentar animar o seu sistema Android, dar uma voz ao seu projeto pode ser...

by Xukyo | 19 Mar 2024 | Tutoriais

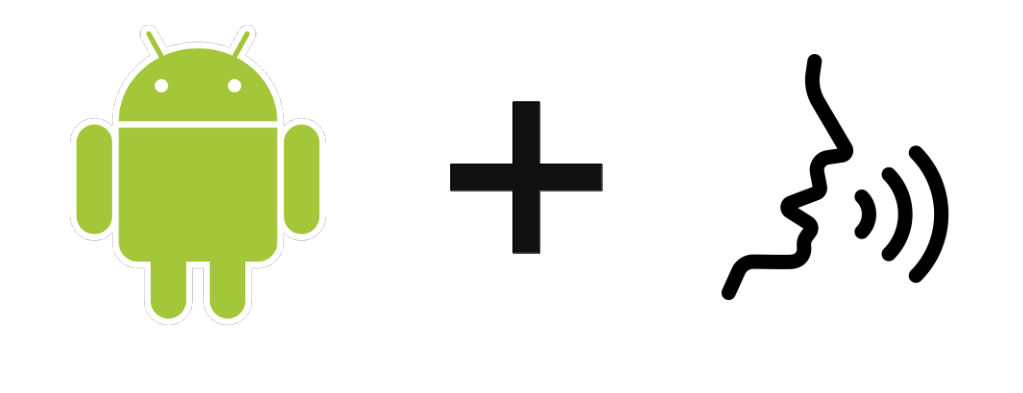

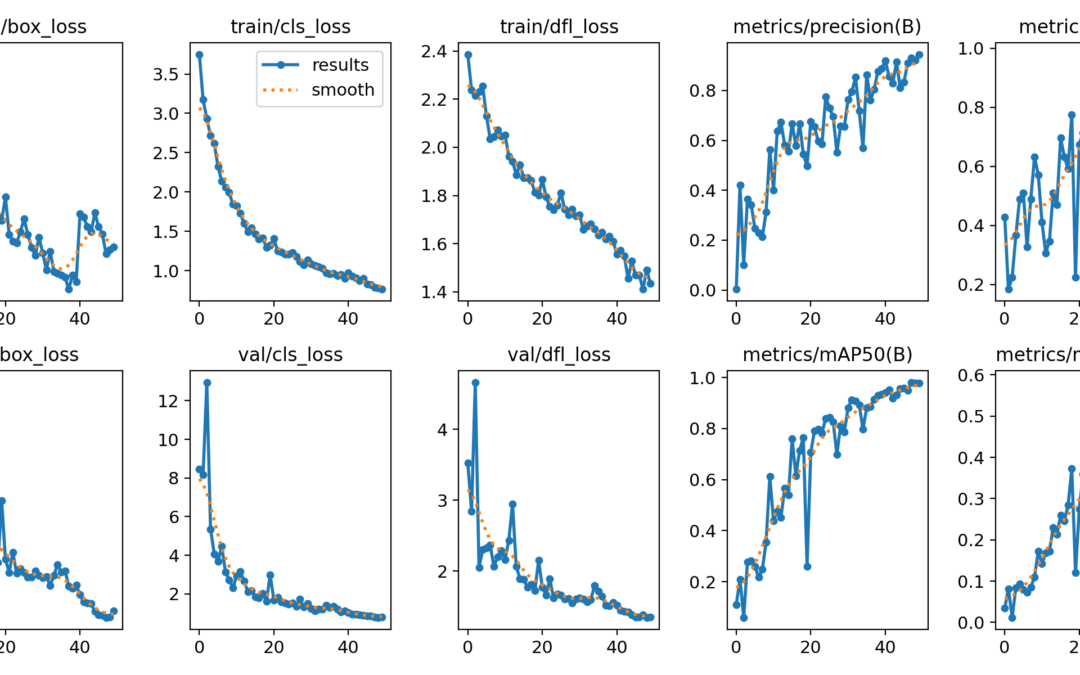

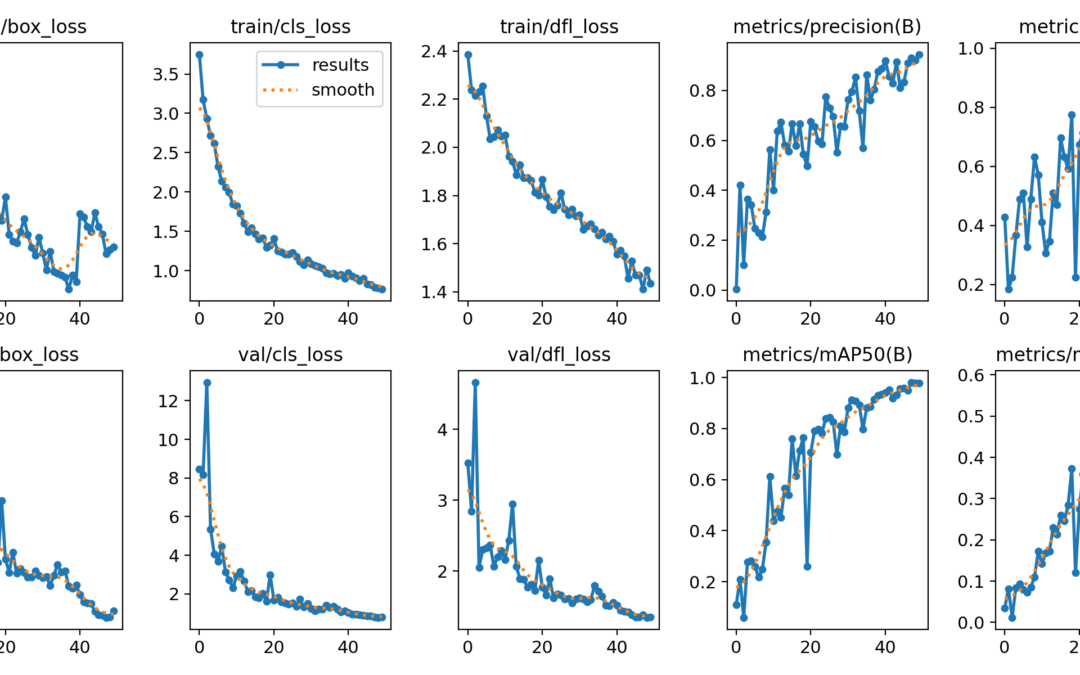

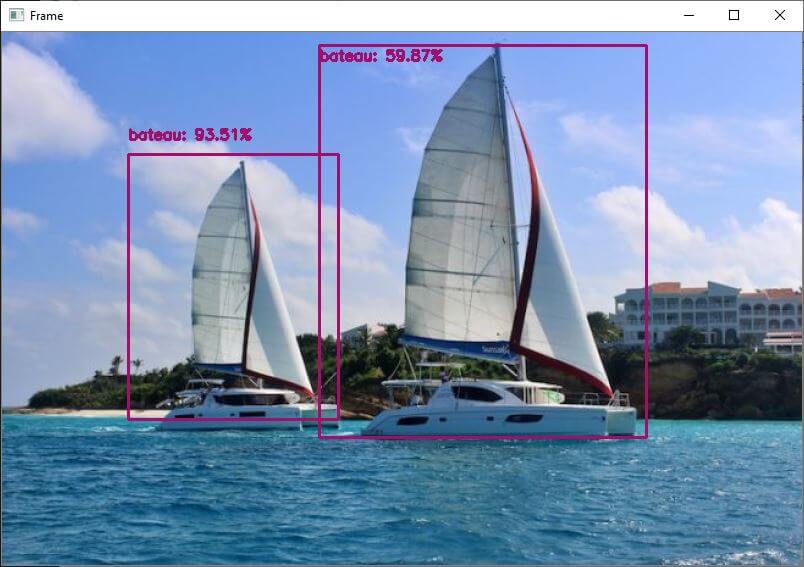

Neste tutorial, vamos ver como treinar um modelo YOLO para reconhecimento de objectos em dados específicos. A dificuldade reside na criação do banco de imagens que será utilizado para o treino. Hardware Um computador com uma instalação Python3 Uma câmara Princípio...

by Xukyo | 4 Mar 2024 | Tutoriais

Para melhorar o desempenho no Raspberry Pi, é possível utilizar a linguagem C++ e bibliotecas optimizadas para acelerar o cálculo dos modelos de deteção de objectos. É isto que o TensorFlow Lite oferece. Um bom ponto de partida é o sítio Web QEngineering. Hardware...

by Xukyo | 3 Mar 2024 | Tutoriais

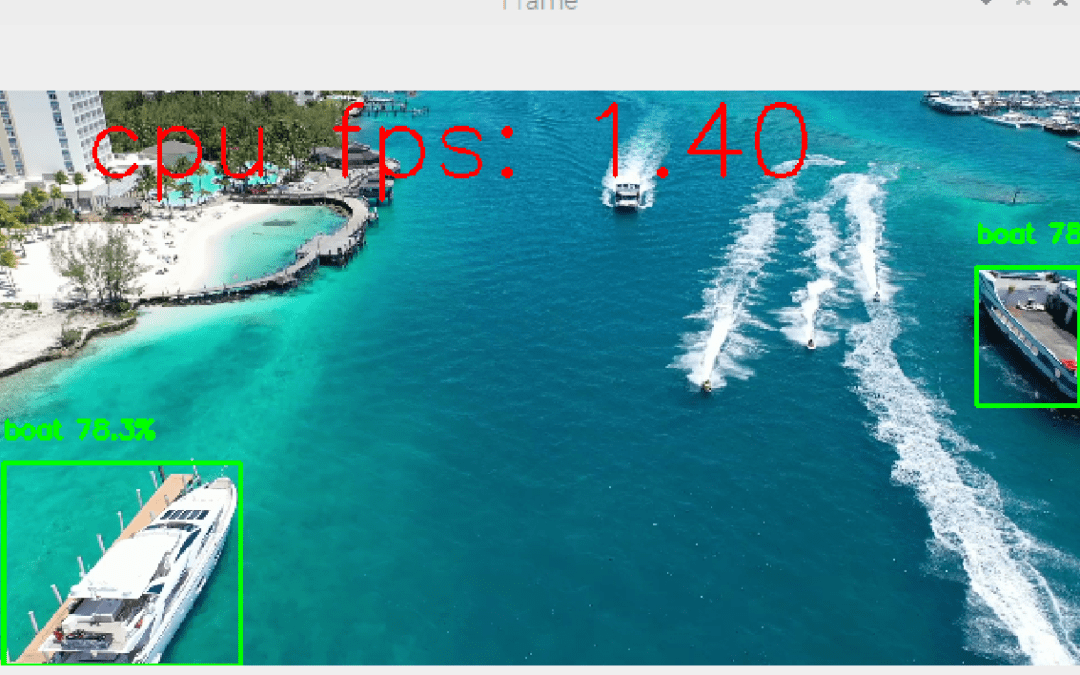

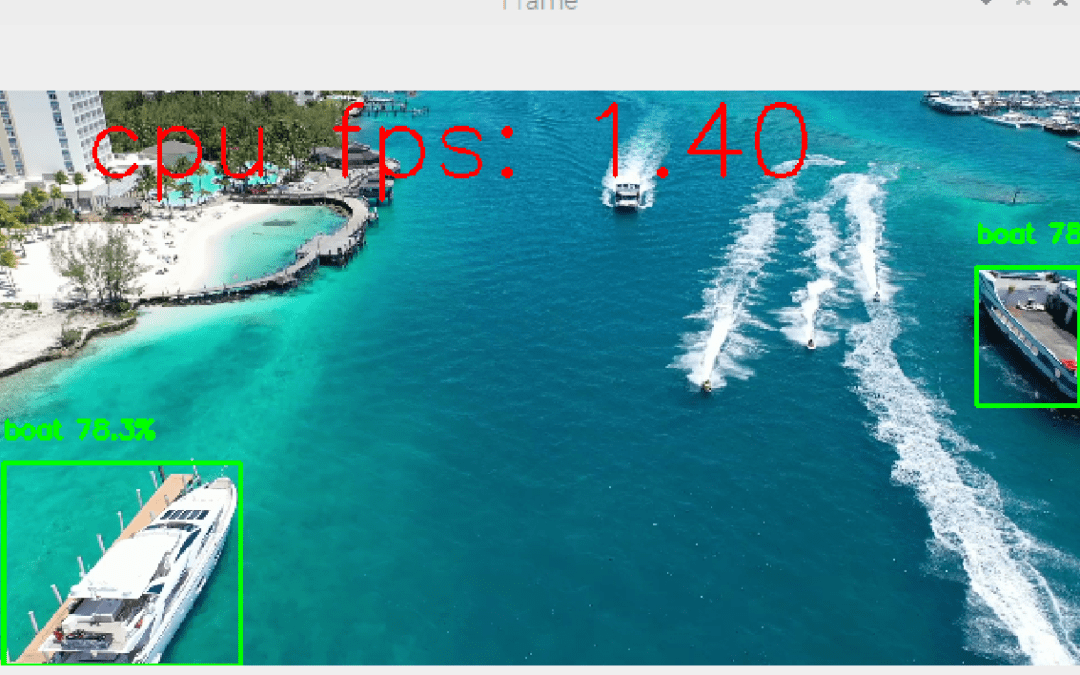

É possível incorporar modelos de reconhecimento de objectos como o Yolo num Raspberry Pi. Naturalmente, devido ao seu baixo desempenho em comparação com os computadores, o desempenho é inferior em termos de reconhecimento em tempo real. No entanto, é perfeitamente...

by Xukyo | 1 Mar 2024 | Tutoriais

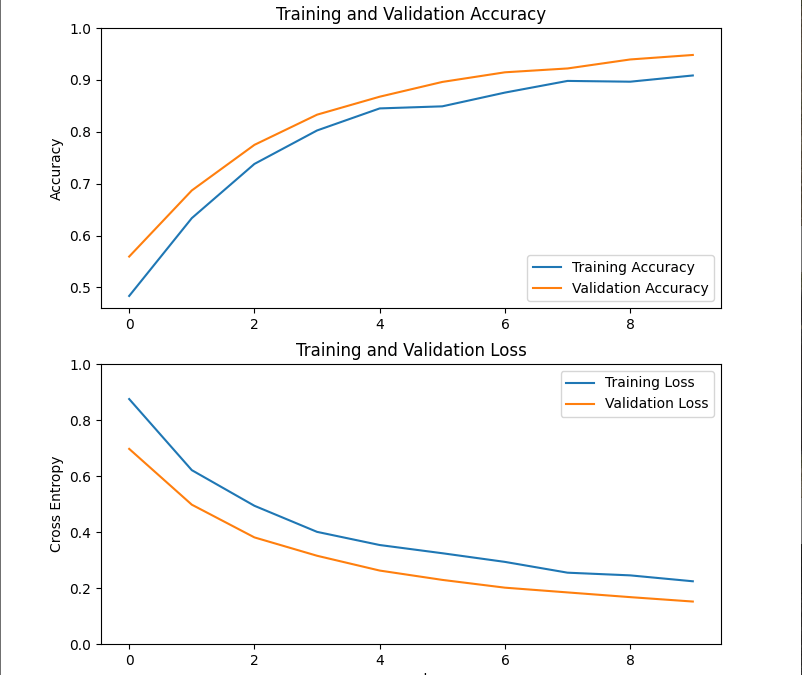

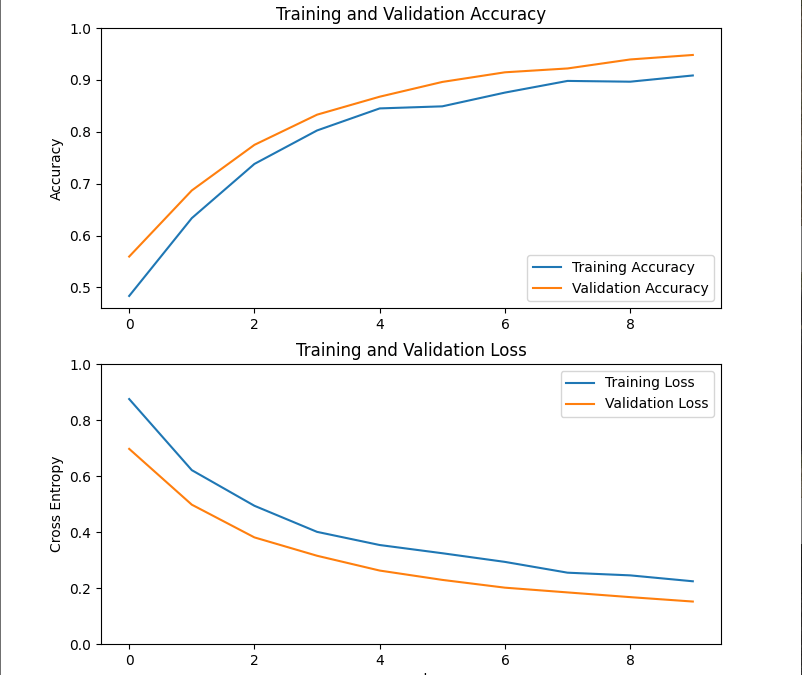

Neste tutorial, vamos treinar um modelo TensorFlow MobileNetV2 com o Keras para que ele possa ser aplicado ao nosso problema. Poderemos então utilizá-lo em tempo real para classificar novas imagens. Para este tutorial, partimos do princípio de que seguiu os tutoriais...